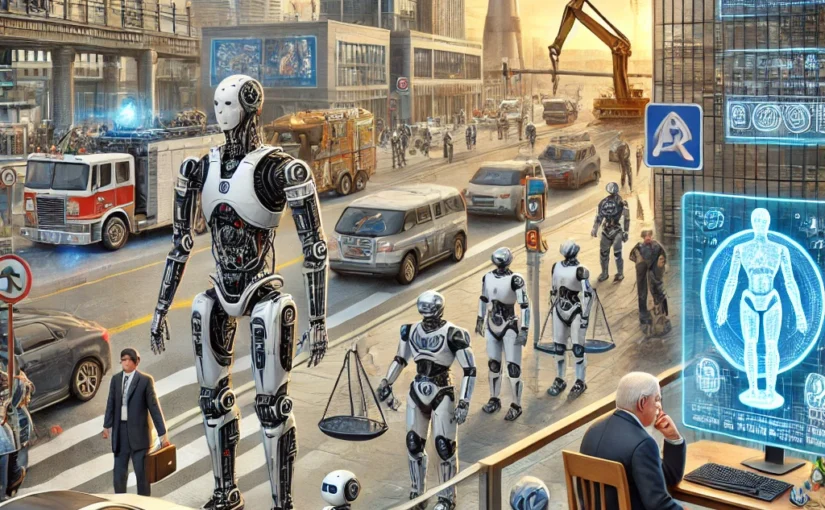

Die Definition und Abgrenzung von Robotern, insbesondere im Kontext von autonomen und intelligenten Robotern, ist entscheidend für die rechtliche und ethische Einordnung dieser Technologien. Während ein traditioneller Roboter in der Regel als eine Maschine verstanden wird, die vorprogrammierte Aufgaben ausführt, zeichnen sich autonome und intelligente Roboter durch ihre Fähigkeit aus, Entscheidungen auf Basis von Umgebungsdaten und Lernprozessen zu treffen.

Definition und Begriffsabgrenzungen

Autonome Roboter sind Systeme, die ohne menschliches Eingreifen in komplexen Umgebungen operieren können. Sie nutzen Sensoren, Algorithmen und maschinelles Lernen, um ihre Umgebung wahrzunehmen, Entscheidungen zu treffen und sich anzupassen. Intelligente Roboter gehen einen Schritt weiter, indem sie nicht nur autonom handeln, sondern auch lernfähig sind und sich über die Zeit hinweg an neue Aufgaben und Umgebungen anpassen können. Diese Fähigkeiten werfen jedoch Fragen zur Verantwortung und Kontrolle auf, da solche Systeme potenziell unvorhersehbare Entscheidungen treffen können.

Ein besonders faszinierender Aspekt in der Diskussion um intelligente Roboter ist das Konzept des Bewusstseins. Obwohl heutige Roboter kein echtes Bewusstsein besitzen, wird in der Philosophie und Robotik intensiv darüber diskutiert, ob und wann Roboter ein Bewusstsein entwickeln könnten, und welche rechtlichen und ethischen Implikationen dies hätte. Bewusstsein bei Robotern würde nicht nur die Art und Weise, wie wir mit Maschinen interagieren, grundlegend verändern, sondern auch neue rechtliche Kategorien erforderlich machen.

Die Abgrenzung zwischen autonomen und intelligenten Robotern hat direkte Auswirkungen auf ihre regulatorische Behandlung und auf die Frage, wie sie in unsere Gesellschaft integriert werden können. Hier kommen Asimovs Gesetze der Robotik ins Spiel, die als frühe ethische Richtlinien für den Umgang mit intelligenten Maschinen konzipiert wurden.

Asimovs Gesetze in der modernen Robotik

Isaac Asimov, ein berühmter Science-Fiction-Autor, entwickelte drei Gesetze der Robotik, die bis heute als Inspirationsquelle für die ethische Gestaltung von Robotern dienen:

- Ein Roboter darf keinen Menschen verletzen oder durch Untätigkeit zulassen, dass einem Menschen Schaden zugefügt wird.

- Ein Roboter muss den Befehlen gehorchen, die ihm von einem Menschen erteilt werden, es sei denn, diese Befehle würden das erste Gesetz verletzen.

- Ein Roboter muss seine eigene Existenz schützen, solange dieser Schutz nicht dem ersten oder zweiten Gesetz widerspricht.

Diese Gesetze bieten einen grundlegenden ethischen Rahmen, aber sie stoßen an ihre Grenzen, wenn es um komplexe moralische Dilemmata geht, die durch moderne Robotik und KI aufgeworfen werden. Beispielsweise könnte ein autonomes Fahrzeug in einer Situation entscheiden müssen, ob es einen Unfall vermeidet und dabei den Fahrer schützt oder Passanten auf der Straße ausweicht. Solche Situationen erfordern komplexere ethische Regeln und eine tiefere Integration von moralischen Überlegungen in die KI-Programmierung.

Haftungsfragen in der Robotik

Autonome Roboter als haftbare Rechtssubjekte?

Die rasante Entwicklung autonomer Roboter stellt das traditionelle Haftungsrecht vor neue Herausforderungen. Ein zentraler Punkt ist die Frage, ob und wie autonome Roboter als haftbare Rechtssubjekte anerkannt werden könnten. Derzeit gibt es keine klare gesetzliche Regelung, die Roboter als eigenständige Rechtspersonen anerkennt. Dies bedeutet, dass bei Schäden, die durch autonome Roboter verursacht werden, in der Regel die Hersteller, Betreiber oder Eigentümer zur Verantwortung gezogen werden.

Die Einführung von Robotern als haftbare Rechtssubjekte erfordert tiefgreifende rechtliche Reformen. Es müsste ein neues Haftungsregime entwickelt werden, das die spezifischen Fähigkeiten und Entscheidungsprozesse dieser Maschinen berücksichtigt. Eine solche Regelung könnte zum Beispiel die Schaffung eines speziellen Rechtsstatus für Roboter umfassen, ähnlich der beschränkten Rechtspersönlichkeit von Unternehmen. Dies würde es ermöglichen, Roboter für ihre Handlungen haftbar zu machen, während gleichzeitig die Verantwortung der Entwickler und Betreiber klar definiert bleibt.

Ein großes Hindernis für die Etablierung von Robotern als haftbare Rechtssubjekte ist das Fehlen eines klaren Verständnisses darüber, wie die Entscheidungsprozesse eines autonomen Systems rechtlich bewertet werden können. Ein Roboter handelt auf Basis von Algorithmen und maschinellem Lernen, was bedeutet, dass seine Entscheidungen nicht immer vorhersehbar sind. Dies macht es schwierig, einen klaren Zusammenhang zwischen der Programmierung und den resultierenden Handlungen zu ziehen, was für die Haftungszuweisung essenziell ist.

Notwendigkeit eines angepassten Haftungsregimes

Es besteht ein dringender Bedarf an einem Haftungsregime, das den besonderen Fähigkeiten von autonomen Robotern gerecht wird. Ein solches Regime müsste flexibel genug sein, um die verschiedenen Arten von Schäden abzudecken, die durch autonome Systeme verursacht werden könnten, und gleichzeitig sicherstellen, dass Opfer von Fehlverhalten fair entschädigt werden.

Ein möglicher Ansatz könnte darin bestehen, eine verschuldensunabhängige Haftung für den Einsatz von Robotern einzuführen. In diesem Modell wäre der Hersteller oder Betreiber eines Roboters für Schäden verantwortlich, unabhängig davon, ob ein Verschulden vorliegt oder nicht. Diese Art der Haftung könnte durch eine obligatorische Versicherungspflicht ergänzt werden, um sicherzustellen, dass Opfer von Robotik-bedingten Unfällen angemessen entschädigt werden.

Ethik in der Robotik

Entwicklung eines ethischen Rahmens: Die ethischen Fragen, die durch den Einsatz von Robotern aufgeworfen werden, sind vielfältig und komplex. Ein ethischer Rahmen für die Gestaltung, Herstellung und Nutzung von Robotern ist unerlässlich, um sicherzustellen, dass diese Technologien im Dienst der Menschheit stehen und keine unnötigen Risiken verursachen.

Ein solcher ethischer Rahmen sollte mehrere zentrale Prinzipien umfassen:

- Schutz der menschlichen Würde: Roboter sollten so gestaltet und programmiert werden, dass sie die Würde und die Rechte der Menschen, mit denen sie interagieren, respektieren. Dies umfasst insbesondere den Schutz vor Überwachung und dem Missbrauch von Daten, die durch Roboter gesammelt werden.

- Verantwortlichkeit und Transparenz: Die Verantwortlichkeit für die Handlungen von Robotern muss klar definiert sein. Dies bedeutet, dass es nachvollziehbare Mechanismen geben muss, die sicherstellen, dass Entscheidungen von Robotern transparent sind und bei Bedarf überprüft werden können.

- Sicherheit und Schutz: Roboter sollten so konstruiert sein, dass sie die Sicherheit der Menschen gewährleisten. Dies umfasst nicht nur den physischen Schutz vor Verletzungen, sondern auch den Schutz vor psychologischen und sozialen Schäden.

- Fairness und Gerechtigkeit: Der Einsatz von Robotern darf nicht zu Diskriminierung oder Ungerechtigkeit führen. Dies bedeutet, dass Algorithmen und Systeme, die Roboter steuern, so gestaltet sein müssen, dass sie fair und unvoreingenommen handeln.

- Nachhaltigkeit: Der Einsatz von Robotern sollte mit Blick auf die ökologischen und sozialen Auswirkungen bewertet werden. Dies schließt die ethische Verantwortung für die Umwelt ein, sowohl in der Herstellung als auch im Betrieb von Robotern.

Resümee

Die Integration von Robotern in unsere Gesellschaft erfordert nicht nur technologische, sondern auch tiefgreifende rechtliche und ethische Überlegungen. Die Abgrenzung von autonomen und intelligenten Robotern, die Diskussion um ihre rechtliche Haftbarkeit und die Entwicklung eines robusten ethischen Rahmens sind wesentliche Schritte, um sicherzustellen, dass diese Technologien sicher und im Sinne der Menschheit eingesetzt werden. Asimovs Gesetze bieten eine erste Orientierung, doch die komplexen Realitäten der modernen Robotik erfordern weitergehende und differenzierte Regelungen, um den Herausforderungen gerecht zu werden, die diese faszinierende Technologie mit sich bringt.

- Entwicklung der Robotik 2025 - Oktober 24, 2025

- Weltmodelle und Datenrecht - Oktober 10, 2025

- Entwicklung der Robotik im Jahr 2025 - Oktober 5, 2025